Linux

- awk

- Цветной вывод в консоли

- Кракозябры в терминале

- OpenVPN in Docker container

- SSH Tunneling

- Memcached

- MongoDB

- SED

- iptables

- Wi-Fi через терминал

- Трекпад на thinkpad x240

- Домашняя система [configs]

- IPsec tunnel [ubuntu - ubuntu]

- deb-пакет

- LUKS Cryptsetup

- Postgresql

- Bash Tricks

- Сжатие/поворот jpeg

- LA

- VIM

- Два монитора

- CAPS -> ESC

- Bluetooth

- Firefox error: NS_ERROR_FILE_CORRUPTED

- DNS NetworkManager

- Сколько ресурсов "продано" на хостере

- Vagrant

- Vagrant

- Packer

- BIND9

- ssh tricks

- Bacula/Bareos

- linux tricks

- Docker and iptables

- Ferm

- openssl

- Процесс загрузки ядра Linux

- systemd/systemctl

- LVM

- network

- dvorak in console

- ini

- apt sources list

- MSSQL

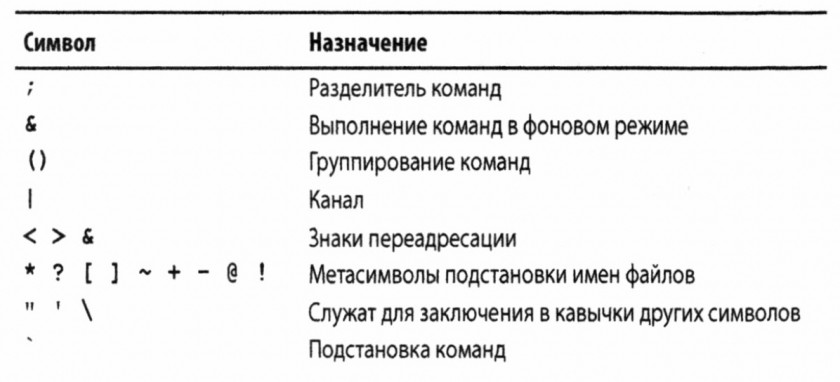

- BASH

- OpenSSL

- LVS

- jq

- Certbot

- Linux hostname (как правильно изменить)

- Своя инфраструктура

- Reproxy

- Borg

- Borgmatic

- mdadm

- cloud-init

- Make

- CouchDB

awk

Статья на хабре от ruvds

Статья на сайте ibm

Синтаксис

~$ awk OPTIONS PROGRAM FILE

-

OPTIONS- опции -

PROGRAM- файл с программой на awk или строка с ней :'{print "Welcome to awk command tutorial"}' -

FILE- файл который нужно обработать

Опции (основные)

-

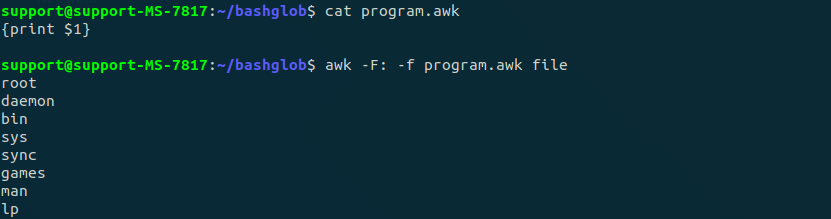

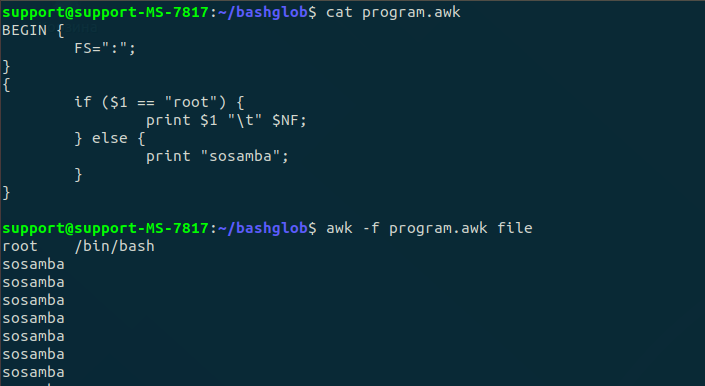

-F fs— позволяет указать символ-разделитель для полей в записи, вот так можно указать его внутри скриптаFS=":" -

-f file— указывает имя файла, из которого нужно прочесть awk-скрипт -

-v var=value— позволяет объявить переменную и задать её значение по умолчанию, которое будет использовать awk -

-mf N— задаёт максимальное число полей для обработки в файле данных -

-mr N— задаёт максимальный размер записи в файле данных -

-W keyword— позволяет задать режим совместимости или уровень выдачи предупреждений awk

Применение

По умолчанию, каждое слово заносится в переменную с именем $<номер слова в строке>, а через переменную $0 можно обратиться ко всей текущей строке, например $3 в текущей строке содержит значение каждое (под словом подразумевается поле выделенное из строки с помощью разделителя (по умолчанию пробел или табуляция))

Скрипты выглядят следующим образом: (точкой с запятой нужно разделять строки если они записаны в одну строку, а если нет то достаточно переноса строки) (чтобы выполнить какие-то инструкции до или после начала обработки текста, нужно добавить перед блоком такого кода соответственно слово BEGIN или END)

BEGIN {

print "sosamba niga mazafaka"

}

{

text = " has a home directory at "

print $1 text $6

}

END {

print "konets sosamby"

}

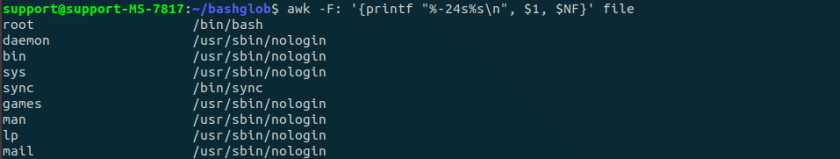

Переменная $NF хранит последнее слово из строки

Переменные для обработки:

- FIELDWIDTHS — разделённый пробелами список чисел, определяющий точную ширину каждого поля данных с учётом разделителей полей

- FS — уже знакомая вам переменная, позволяющая задавать символ-разделитель полей

- RS — переменная, которая позволяет задавать символ-разделитель записей

- OFS — разделитель полей на выводе awk-скрипта

- ORS — разделитель записей на выводе awk-скрипта

Пременные окружающей среды:

- ARGC — количество аргументов командной строки

- ARGV — массив с аргументами командной строки

- ARGIND — индекс текущего обрабатываемого файла в массиве ARGV

- ENVIRON — ассоциативный массив с переменными окружения и их значениями

- ERRNO — код системной ошибки, которая может возникнуть при чтении или закрытии входных файлов

- FILENAME — имя входного файла с данными

- FNR — номер текущей записи в файле данных

- IGNORECASE — если эта переменная установлена в ненулевое значение, при обработке игнорируется регистр символов

- NF — общее число полей данных в текущей записи

- NR — общее число обработанных записей

Например можно узнавать внутри скрипта об указанных ключах и значениях в команде или о домашей директории

Условный оператор

Однострочный вариант

if (УСЛОВИЕ) ДЕЙСТВИЕ

Обычный (если нужно выполниь несколько строк кода, то их нужно объединить фигурными скобками)

if (УСЛОВИЕ)

{

ДЕЙСТВИЕ1

ДЕЙСТВИЕ2

}

Циклы

Можно использовать оператор break и continue

- while

while (УСЛОВИЕ)

{

ДЕЙСТВИЕ1

ДЕЙСТВИЕ2

}

- for -

for (ИНИЦИАЛИЗАЦИЯ_СЧЕТЧИКА; УСЛОВИЕ; ИНКРЕМЕНТАЦИЯ) # как в С-подобных языках

{

ДЕЙСТВИЕ1

ДЕЙСТВИЕ2

}

Фарматированный вывод printf

Вывод настраивается через спецификаторы в формате %[modifier]control-letter

Список спецификаторов:

- c - воспринимает переданное ему число как код ASCII-символа и выводит этот символ

- d - выводит десятичное целое число

- i - то же самое, что и d

- e - выводит число в экспоненциальной форме

- f - выводит число с плавающей запятой

- g - выводит число либо в экспоненциальной записи, либо в формате с плавающей запятой, в зависимости от того, как получается короче

- o - выводит восьмеричное представление числа

- s - выводит текстовую строку

Пример:

printf "The result is: %e\n", x

Встроенные функции

Ссылка на gnu.org на страницу с функциями

Пользовательские функции

function ИМЯ_ФУНКЦИИ()

{

ТЕЛО_ФУНКЦИИ

}

Цветной вывод в консоли

Escape-последовательность для указания цвета текста:

\x1b[...m

\x1b[ - начало

... - место для твоих параметров

m - конец

Коды и атрибуты перечисляются через ;

Пример:

[vandud@vps9104 ~]$ echo -e "\x1b[4;1;41;32mNigaMazafaka\nNigaMazafaka\x1b[0m"

| атрибут | значение |

|---|---|

| 0 | нормальный режим |

| 1 | жирный |

| 4 | подчеркнутый |

| 5 | мигающий |

| 7 | инвертированные цвета |

| 8 | невидимый |

| код для фона | код для текста | цвет |

|---|---|---|

| 40 | 30 | черный |

| 41 | 31 | красный |

| 42 | 32 | зеленый |

| 43 | 33 | желтый |

| 44 | 34 | синий |

| 45 | 35 | пурпурный |

| 46 | 36 | голубой |

| 47 | 37 | белый |

Последовательность \x1b[0m - Сбрасывает изменения к дефолтным

Кракозябры в терминале

Пример, который был получен выводом командой cat файлов из директории /bin:

for i in `ls -1 /bin`; do cat /bin/$i; done

Такое происходит из-за управляющих последовательностей (escape-последовательностей), которые были посланы в терминал.

https://www.opennet.ru/man.shtml?topic=console_codes&category=4&russian=0

При выводе какого-либо бинарного файла, символы в нем могут образовывать такие последовательности. Из-за этого терминал меняет свое поведение и начинает показывать кракозябры.

Это можно починить перезайдя в оболочку (так как эти последовательности применяют изменения только в рамках текущей сессии).

Либо если возможности перезайти нет, можно выполнить команду reset, несмотря на то что в поле ввода команды будут кракозябры, эта команда выполнится и перезапустит оболочку (без перелогинивания).

Об этом написано тут http://www.linuxcookbook.ru/howto/Text-Terminal/Text-Terminal-14.html

OpenVPN in Docker container

https://habr.com/ru/post/354632/

Копируем следующие строчки в созданный docker-compose.yml

version: '2'

services:

openvpn:

cap_add:

- NET_ADMIN

image: kylemanna/openvpn

container_name: openvpn

ports:

- "1194:1194/udp"

restart: always

volumes:

- /home/vandud/docker/openvpn/config:/etc/openvpn

Далее

docker-compose run --rm openvpn ovpn_genconfig -u udp://vandud.ru

docker-compose run --rm openvpn ovpn_initpki

Enter New CA Passphrase: niga

Common Name (eg: your user, host, or server name) [Easy-RSA CA]:vandudca

Потом дважды ввел пароль niga

[vandud@vps9104 openvpn]$ docker-compose up -d openvpn

Creating openvpn ... done

Создание серта

docker-compose run --rm openvpn easyrsa build-client-full vandud-phone nopass

Ввести пароль niga

docker-compose run --rm openvpn ovpn_getclient vandud-phone > certificate.ovpn

В получившемся файле только сертификаты и ключи, но нет параметров подключения

Нужно добавить в начало файла следующее

dev tun

proto udp

remote 51.255.215.177

port 1194

client

resolv-retry infinite

tls-client

key-direction 1

auth SHA1

cipher BF-CBC

persist-key

persist-tun

verb 3

Все работает

Чтобы добавить в автозагрузку с systemd

Надо в /etc/openvpn/client.conf положить конфиг (.ovpn)

И добавить в автозагрузку systemctl enable openvpn@client.service

Вот тут написано как делать

https://www.smarthomebeginner.com/configure-openvpn-to-autostart-linux/

Fri Mar 5 04:17:57 2021 write to TUN/TAP : Invalid argument (code=22)

Возникла такая ошибка (сыпется подряд и ничего не грузится)

Клиент - старый дебиан, Сервер - новый докер-контейнер

Решилась так

openvpn --config zabbix-server-1.8.22-web.ovpn --comp-lzo

SSH Tunneling

https://habr.com/ru/post/435546/

-

SSH Socks Proxy

Все очень просто.

Подключаемся по ssh к серверу или какому либо хосту (через который будем проксировать трафик) с добавлением ключа -D и вместе с ним указываем порт.

~$ ssh connect@vandud.ru -D 8888

После этого нужно настроить подключение в приложении трафик которого нужно проксировать. Например firefox

В настройках подключения указываем localhost и указанный ранне порт 8888, все.

Готово, трафик со всех приложений идет по-старому, кроме настроенного приложения (firefox)

-

SSH Туннель (переадресация портов)

~$ ssh -L 8888:127.0.0.1:80 root@45.8.228.69

Эта команда создает защищенный туннель между локальным хостом и удаленным (но только между определенными портами).

То есть при подключении к порту 8888 на локальной машине, запрос идет на 80 порт удаленной машины (конкретно в этом примере). Вместо 127.0.0.1 можно указать какой либо другой адрес, и запрос будет идти на него (от имени удаленной машины)

На скриншоте это видно (на удаленной машине установлен nginx и при запросе на localhost:80 отдается страница wp)

Еще пример

Делаю вот такую команду

vandud@vandud-workstation:~$ ssh -L 8888:95.214.62.136:443 root@45.8.228.69

Она означает, что при подключении к localhost:8888 подключаться к 95.214.62.136:443 от имени 45.8.228.69. Это действительно работает.

Можно также указать локальный адрес

vandud@vandud-workstation:~$ ssh -4 -L 0.0.0.0:8888:95.214.62.136:443 root@45.8.228.69

Получается то же самое

vandud@vandud-workstation:~$ openssl s_client -connect 0.0.0.0:8888 | grep "subject"

Can't use SSL_get_servername

depth=2 O = Digital Signature Trust Co., CN = DST Root CA X3

verify return:1

depth=1 C = US, O = Let's Encrypt, CN = Let's Encrypt Authority X3

verify return:1

depth=0 CN = alexgyver.ru

verify return:1

subject=CN = alexgyver.ru

^C

Но не работает когда указываешь белые адреса (не локальные)

-

Обратный SSH Туннель

С помощью обратного ssh-туннеля можно получать доступ к мошине за NAT

В качестве примера, сделаю это с рабочим компьютером (он за NAT) и VPS сервером (с него буду подключаться к рабочему компу).

На рабочем компе делаю следующее

vandud@vandud-workstation:~$ ssh root@45.8.228.69 -R localhost:222:localhost:22 -N

root@45.8.228.69's password:

Конструкция -R localhost:222:localhost:22 означает, что при подключении на удаленной машине к localhost:222 подключаться к рабочему компьютеру на порт 22.

Ключ -N указывает, что не нужно запускать оболочку (после такого подключения работать с машиной по ssh не получится, так как нет приглашения -> некуда вводить команды).

Далее нужно с VPS ввести следующую команду

root@vandud-main-server:~# ssh vandud@localhost -p 222

Ввести пароль и все. Таким образом можно подключаться по ssh к рабочему компьютеру с удаленной VPS

-

SSHFS (дотестить и написать тут)(пункт 16 в статье на хабре)

Memcached

Запущенный memcached

root@vandud:/etc# systemctl status memcached

● memcached.service - memcached daemon

Loaded: loaded (/lib/systemd/system/memcached.service; enabled; vendor preset: enabled)

Active: active (running) since Tue 2019-11-12 10:46:25 UTC; 9min ago

Docs: man:memcached(1)

Main PID: 9066 (memcached)

Tasks: 10 (limit: 1073)

CGroup: /system.slice/memcached.service

└─9066 /usr/bin/memcached -m 64 -p 11211 -u memcache -l 127.0.0.1 -P /var/run/memcached/memcached.pid

Nov 12 10:46:25 vandud systemd[1]: Started memcached daemon.

Конфиг memcached'a

root@vandud:/etc# grep -vE '^#|^$' memcached.conf

-d

logfile /var/log/memcached.log

-m 64

-p 11211

-u memcache

-l 127.0.0.1

-P /var/run/memcached/memcached.pid

Как видно, он берет данные из конфига и запускает с ними себя.

Для работы с memcached нужно подключиться к сервису на порт на котором он запущен (например через nc, можно также через telnet)

Запись данных

root@vandud:~# echo -e 'add TEST 0 0 3\r\n101\r' | nc localhost 11211

STORED

^C

root@vandud:~# echo -e 'get TEST\r' | nc localhost 11211

VALUE TEST 0 3

101

END

Пример запроса

echo -e 'add KEY 0 0 5\r\nVALUE\r' | nc localhost 11211

В нем указано, что нужно создать ключ KEY который имеет

- флаг 0 (флаги существуют и их можно использовать на свое усмотрение)

- неограниченное время жизни (второй ноль означает пока не уберут этот ключ вручную)

- длину 5 байт

- значение VALUE равное 5 байт

Также нужно обратить внимание, что memcached сначала проверяет корректность данных (например указано что будет 5 байт данных, а передано 6, такой запрос завершится с ошибкой данных), а потом пытается их засунуть в ключ (то есть потом уже он смотрит на существование запрашиваемого ключа (на случай запроса к несуществующему ключу))

Замена значений

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

VALUE KEY 0 5

TESTS

END

^C

root@vandud:~# echo -e 'set KEY 0 0 3\r\nkey\r' | nc localhost 11211

STORED

^C

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

VALUE KEY 0 3

key

END

Удаление ключа со значением

root@vandud:~# echo -e 'delete KEY\r' | nc localhost 11211

DELETED

^C

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

END

^C

Инкремен\Декремент (только если значение ключа числовое, иначе ошибка)

root@vandud:~# echo -e 'set KEY 0 0 3\r\n333\r' | nc localhost 11211

STORED

^C

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

VALUE KEY 0 3

333

END

^C

root@vandud:~# echo -e 'incr KEY 333\r' | nc localhost 11211

666

^C

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

VALUE KEY 0 3

666

END

^C

root@vandud:~# echo -e 'decr KEY 111\r' | nc localhost 11211

555

^C

root@vandud:~# echo -e 'get KEY\r' | nc localhost 11211

VALUE KEY 0 3

555

END

MongoDB

В качестве идентификатора используется поле _id (именно с подчеркиванием)

Для того чтобы войти в MongoShell, нужно ввести команду mongo, также можно сразу указать имя базы mongo mydb (это заменяет команду use mydb)

Для того чтобы импортировать свою базу нужно выполнить следующую команду

~# mongoimport -v --file=zips.json

2019-11-12T16:05:10.757+0000 no collection specified

2019-11-12T16:05:10.758+0000 using filename 'zips' as collection

2019-11-12T16:05:10.760+0000 filesize: 3182409 bytes

2019-11-12T16:05:10.761+0000 using fields:

2019-11-12T16:05:10.781+0000 connected to: localhost

2019-11-12T16:05:10.782+0000 ns: test.zips

2019-11-12T16:05:10.782+0000 connected to node type: standalone

2019-11-12T16:05:10.784+0000 using write concern: w='1', j=false, fsync=false, wtimeout=0

2019-11-12T16:05:10.784+0000 using write concern: w='1', j=false, fsync=false, wtimeout=0

2019-11-12T16:05:11.758+0000 imported 29353 documents

Посмотреть список коллекций в базе

> use test

switched to db test

> show collections

zips

>

Поиск по базе

> db.zips.find({'_id': '01001'})

{ "_id" : "01001", "city" : "AGAWAM", "loc" : [ -72.622739, 42.070206 ], "pop" : 15338, "state" : "MA" }

>

Показать все документы в базе

> db.zips.find({})

{ "_id" : "01001", "city" : "AGAWAM", "loc" : [ -72.622739, 42.070206 ], "pop" : 15338, "state" : "MA" }

{ "_id" : "01002", "city" : "CUSHMAN", "loc" : [ -72.51565, 42.377017 ], "pop" : 36963, "state" : "MA" }

{ "_id" : "01005", "city" : "BARRE", "loc" : [ -72.108354, 42.409698 ], "pop" : 4546, "state" : "MA" }

{ "_id" : "01007", "city" : "BELCHERTOWN", "loc" : [ -72.410953, 42.275103 ], "pop" : 10579, "state" : "MA" }

{ "_id" : "01008", "city" : "BLANDFORD", "loc" : [ -72.936114, 42.182949 ], "pop" : 1240, "state" : "MA" }

{ "_id" : "01010", "city" : "BRIMFIELD", "loc" : [ -72.188455, 42.116543 ], "pop" : 3706, "state" : "MA" }

{ "_id" : "01011", "city" : "CHESTER", "loc" : [ -72.988761, 42.279421 ], "pop" : 1688, "state" : "MA" }

{ "_id" : "01012", "city" : "CHESTERFIELD", "loc" : [ -72.833309, 42.38167 ], "pop" : 177, "state" : "MA" }

{ "_id" : "01013", "city" : "CHICOPEE", "loc" : [ -72.607962, 42.162046 ], "pop" : 23396, "state" : "MA" }

{ "_id" : "01020", "city" : "CHICOPEE", "loc" : [ -72.576142, 42.176443 ], "pop" : 31495, "state" : "MA" }

{ "_id" : "01022", "city" : "WESTOVER AFB", "loc" : [ -72.558657, 42.196672 ], "pop" : 1764, "state" : "MA" }

{ "_id" : "01026", "city" : "CUMMINGTON", "loc" : [ -72.905767, 42.435296 ], "pop" : 1484, "state" : "MA" }

{ "_id" : "01027", "city" : "MOUNT TOM", "loc" : [ -72.679921, 42.264319 ], "pop" : 16864, "state" : "MA" }

{ "_id" : "01028", "city" : "EAST LONGMEADOW", "loc" : [ -72.505565, 42.067203 ], "pop" : 13367, "state" : "MA" }

{ "_id" : "01030", "city" : "FEEDING HILLS", "loc" : [ -72.675077, 42.07182 ], "pop" : 11985, "state" : "MA" }

{ "_id" : "01031", "city" : "GILBERTVILLE", "loc" : [ -72.198585, 42.332194 ], "pop" : 2385, "state" : "MA" }

{ "_id" : "01032", "city" : "GOSHEN", "loc" : [ -72.844092, 42.466234 ], "pop" : 122, "state" : "MA" }

{ "_id" : "01033", "city" : "GRANBY", "loc" : [ -72.520001, 42.255704 ], "pop" : 5526, "state" : "MA" }

{ "_id" : "01034", "city" : "TOLLAND", "loc" : [ -72.908793, 42.070234 ], "pop" : 1652, "state" : "MA" }

{ "_id" : "01035", "city" : "HADLEY", "loc" : [ -72.571499, 42.36062 ], "pop" : 4231, "state" : "MA" }

Type "it" for more

>

Показывает порциями, чтобы показать еще нужно набрать it

Поиск документов по условиям через И

> db.zips.find({'city':'GOSHEN','state':'MA'})

{ "_id" : "01032", "city" : "GOSHEN", "loc" : [ -72.844092, 42.466234 ], "pop" : 122, "state" : "MA" }

>

Через ИЛИ

> db.zips.find({$or: [{'city':'GOSHEN'},{'state':'MA'}]})

{ "_id" : "01001", "city" : "AGAWAM", "loc" : [ -72.622739, 42.070206 ], "pop" : 15338, "state" : "MA" }

{ "_id" : "01002", "city" : "CUSHMAN", "loc" : [ -72.51565, 42.377017 ], "pop" : 36963, "state" : "MA" }

{ "_id" : "01005", "city" : "BARRE", "loc" : [ -72.108354, 42.409698 ], "pop" : 4546, "state" : "MA" }

{ "_id" : "01007", "city" : "BELCHERTOWN", "loc" : [ -72.410953, 42.275103 ], "pop" : 10579, "state" : "MA" }

{ "_id" : "01008", "city" : "BLANDFORD", "loc" : [ -72.936114, 42.182949 ], "pop" : 1240, "state" : "MA" }

{ "_id" : "01010", "city" : "BRIMFIELD", "loc" : [ -72.188455, 42.116543 ], "pop" : 3706, "state" : "MA" }

{ "_id" : "01011", "city" : "CHESTER", "loc" : [ -72.988761, 42.279421 ], "pop" : 1688, "state" : "MA" }

{ "_id" : "01012", "city" : "CHESTERFIELD", "loc" : [ -72.833309, 42.38167 ], "pop" : 177, "state" : "MA" }

{ "_id" : "01013", "city" : "CHICOPEE", "loc" : [ -72.607962, 42.162046 ], "pop" : 23396, "state" : "MA" }

{ "_id" : "01020", "city" : "CHICOPEE", "loc" : [ -72.576142, 42.176443 ], "pop" : 31495, "state" : "MA" }

{ "_id" : "01022", "city" : "WESTOVER AFB", "loc" : [ -72.558657, 42.196672 ], "pop" : 1764, "state" : "MA" }

{ "_id" : "01026", "city" : "CUMMINGTON", "loc" : [ -72.905767, 42.435296 ], "pop" : 1484, "state" : "MA" }

{ "_id" : "01027", "city" : "MOUNT TOM", "loc" : [ -72.679921, 42.264319 ], "pop" : 16864, "state" : "MA" }

{ "_id" : "01028", "city" : "EAST LONGMEADOW", "loc" : [ -72.505565, 42.067203 ], "pop" : 13367, "state" : "MA" }

{ "_id" : "01030", "city" : "FEEDING HILLS", "loc" : [ -72.675077, 42.07182 ], "pop" : 11985, "state" : "MA" }

{ "_id" : "01031", "city" : "GILBERTVILLE", "loc" : [ -72.198585, 42.332194 ], "pop" : 2385, "state" : "MA" }

{ "_id" : "01032", "city" : "GOSHEN", "loc" : [ -72.844092, 42.466234 ], "pop" : 122, "state" : "MA" }

{ "_id" : "01033", "city" : "GRANBY", "loc" : [ -72.520001, 42.255704 ], "pop" : 5526, "state" : "MA" }

{ "_id" : "01034", "city" : "TOLLAND", "loc" : [ -72.908793, 42.070234 ], "pop" : 1652, "state" : "MA" }

{ "_id" : "01035", "city" : "HADLEY", "loc" : [ -72.571499, 42.36062 ], "pop" : 4231, "state" : "MA" }

Type "it" for more

>

То есть используется оператор $or, далее в квадратных скобках идет список значений в фигурных скобках

Поиск документов, где одно поле равно либо одному значению либо другому

> db.zips.find({'city':{$in:['AGAWAM','CUSHMAN']}})

{ "_id" : "01001", "city" : "AGAWAM", "loc" : [ -72.622739, 42.070206 ], "pop" : 15338, "state" : "MA" }

{ "_id" : "01002", "city" : "CUSHMAN", "loc" : [ -72.51565, 42.377017 ], "pop" : 36963, "state" : "MA" }

{ "_id" : "72526", "city" : "CUSHMAN", "loc" : [ -91.776455, 35.869663 ], "pop" : 336, "state" : "AR" }

>

Проецирование (что отображать, а что нет (при поиске))

Отобразить только айди и город

> db.zips.find({'city':{$in:['AGAWAM','CUSHMAN']}},{'_id':1,'city':1})

{ "_id" : "01001", "city" : "AGAWAM" }

{ "_id" : "01002", "city" : "CUSHMAN" }

{ "_id" : "72526", "city" : "CUSHMAN" }

>

При этом если указать только city

> db.zips.find({'city':{$in:['AGAWAM','CUSHMAN']}},{'city':1})

{ "_id" : "01001", "city" : "AGAWAM" }

{ "_id" : "01002", "city" : "CUSHMAN" }

{ "_id" : "72526", "city" : "CUSHMAN" }

>

То id все равно отображается (поэтому можно указать "не отображать id")

> db.zips.find({'city':{$in:['AGAWAM','CUSHMAN']}},{'city':1,'_id':0})

{ "city" : "AGAWAM" }

{ "city" : "CUSHMAN" }

{ "city" : "CUSHMAN" }

>

Но это сработает только с id, потому что это особое поле, например следующий запрос будет с ошибкой (потому что при проецировании поля должны иметь одинаковые значения (1 или 0))

> db.zips.find({'city':{$in:['AGAWAM','CUSHMAN']}},{'city':1,'pop':0})

Error: error: {

"ok" : 0,

"errmsg" : "Projection cannot have a mix of inclusion and exclusion.",

"code" : 2,

"codeName" : "BadValue"

}

>

Сортировка

> db.zips.find().sort({'_id':-1})

{ "_id" : "99950", "city" : "KETCHIKAN", "loc" : [ -133.18479, 55.942471 ], "pop" : 422, "state" : "AK" }

{ "_id" : "99929", "city" : "WRANGELL", "loc" : [ -132.352918, 56.433524 ], "pop" : 2573, "state" : "AK" }

{ "_id" : "99927", "city" : "POINT BAKER", "loc" : [ -133.376372, 56.307858 ], "pop" : 426, "state" : "AK" }

{ "_id" : "99926", "city" : "METLAKATLA", "loc" : [ -131.579001, 55.121491 ], "pop" : 1469, "state" : "AK" }

{ "_id" : "99925", "city" : "KLAWOCK", "loc" : [ -133.055503, 55.552611 ], "pop" : 851, "state" : "AK" }

{ "_id" : "99923", "city" : "HYDER", "loc" : [ -130.124915, 55.925867 ], "pop" : 116, "state" : "AK" }

{ "_id" : "99922", "city" : "HYDABURG", "loc" : [ -132.633175, 55.137406 ], "pop" : 891, "state" : "AK" }

{ "_id" : "99921", "city" : "CRAIG", "loc" : [ -133.117081, 55.47317 ], "pop" : 1398, "state" : "AK" }

{ "_id" : "99919", "city" : "THORNE BAY", "loc" : [ -132.513815, 55.66086 ], "pop" : 744, "state" : "AK" }

{ "_id" : "99901", "city" : "KETCHIKAN", "loc" : [ -131.683175, 55.372028 ], "pop" : 13886, "state" : "AK" }

{ "_id" : "99840", "city" : "SKAGWAY", "loc" : [ -135.301794, 59.468471 ], "pop" : 692, "state" : "AK" }

{ "_id" : "99835", "city" : "SITKA", "loc" : [ -135.316569, 57.051436 ], "pop" : 8638, "state" : "AK" }

{ "_id" : "99833", "city" : "PETERSBURG", "loc" : [ -133.160683, 56.827134 ], "pop" : 4253, "state" : "AK" }

{ "_id" : "99829", "city" : "HOONAH", "loc" : [ -135.558435, 58.032237 ], "pop" : 1670, "state" : "AK" }

{ "_id" : "99827", "city" : "HAINES", "loc" : [ -135.542032, 59.251886 ], "pop" : 2246, "state" : "AK" }

{ "_id" : "99826", "city" : "GUSTAVUS", "loc" : [ -135.761542, 58.42835 ], "pop" : 258, "state" : "AK" }

{ "_id" : "99824", "city" : "DOUGLAS", "loc" : [ -134.395041, 58.275597 ], "pop" : 1802, "state" : "AK" }

{ "_id" : "99820", "city" : "ANGOON", "loc" : [ -134.371052, 57.569832 ], "pop" : 1002, "state" : "AK" }

{ "_id" : "99801", "city" : "JUNEAU", "loc" : [ -134.529429, 58.362767 ], "pop" : 24947, "state" : "AK" }

{ "_id" : "99789", "city" : "NUIQSUT", "loc" : [ -150.997119, 70.192737 ], "pop" : 354, "state" : "AK" }

Type "it" for more

>

У функции sort указывается поле по которому нужно сортировать, и указывается как сортировать (возрастание\убывание)(1-1 соотв.)

Подсчитать количество документов в выборке

> db.zips.find().sort({'_id':-1}).count()

29353

>

Также есть функции skip(N) и limit(N), для того чтобы пропустить первые N документов и вывести только N первых документов в выборке

Вставить значение

> db.zips.insertOne({

... 'field1':'val1',

... 'field2':'val2'

... })

{

"acknowledged" : true,

"insertedId" : ObjectId("5dcae56343b4da469bb68a61")

}

> db.zips.find({'field1':'val1'})

{ "_id" : ObjectId("5dcae56343b4da469bb68a61"), "field1" : "val1", "field2" : "val2" }

>

Замена значения

> db.zips.find({'_id':'01001'},{'state':1})

{ "_id" : "01001", "state" : "niga" }

> db.zips.updateOne({'_id':'01001'},{$set: {'state':'mazafaka'}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.zips.find({'_id':'01001'},{'state':1})

{ "_id" : "01001", "state" : "mazafaka" }

>

Удаление документа

> db.zips.remove({'_id':'01001'})

WriteResult({ "nRemoved" : 1 })

> db.zips.find({'_id':'01001'})

>

Информация о базе (размеры и пр.)

> db.stats()

{

"db" : "test",

"collections" : 1,

"views" : 0,

"objects" : 29353,

"avgObjSize" : 94.50815930228596,

"dataSize" : 2774098,

"storageSize" : 1724416,

"numExtents" : 0,

"indexes" : 1,

"indexSize" : 364544,

"fsUsedSize" : 1849679872,

"fsTotalSize" : 15426048000,

"ok" : 1

}

SED

i.dudin@idudin-vb:~/Documents$ echo "test test niga mazafaka" | sed 's/test/azaza/'

azaza test niga mazafaka

i.dudin@idudin-vb:~/Documents$ echo "test test niga mazafaka" | sed 's/test/azaza/g'

azaza azaza niga mazafaka

Если применять команду к файлу (а не к stdin), то содержимое файла не изменяется (он просто берет текст из файла на обработку и результат выводит)

Чтобы выполнить несколько инструкций нужно использовать ключ -e

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

test

niga

niga

mazafaka

i.dudin@idudin-vb:~/Documents$ sed -e 's/test/niga/g; s/mazafaka/niga/g' test

niga1

niga

niga

niga

niga

niga

niga

Ключ -f нужен для указания файла со скриптом

Кроме флага g у команды замены (s) есть и другие флаги, например можно указывать номер вхождения которое нужно заменить или записать вывод в файл (sed 's/test/new test/w filename' text)

Можно указывать диапазоны обрабатываемых строк

Во второй строке (если в ней есть вхождение) сделать замену

i.dudin@idudin-vb:~/Documents$ sed '3s/niga/1/' test

test1

niga

mazafaka

test

niga

niga

mazafaka

Начиная с 5 и до конца сделать замену

i.dudin@idudin-vb:~/Documents$ sed '5,$s/niga/1/' test

test1

niga

mazafaka

test

1

1

mazafaka

Первое значение не может быть больше второго при указании диапазона, также при указании диапазона не работает флаг g

Поиск подходящей строки по фильтру

Перед командой замены указывается фильтр

Пример: (если в строке встречается test1, то в этой строке заменить первое вхождение mazafaka на 000) (работает со всеми подходящими по фильтр строками)

i.dudin@idudin-vb:~/Documents$ cat newtest

test1 niga test1 mazafaka test1

niga niga niga mazafaka niga

mazafaka niga mazafaka mazafaka mazafaka

test1 niga test mazafaka test

niga niga niga mazafaka niga

niga niga niga mazafaka niga

mazafaka niga mazafaka mazafaka mazafaka

i.dudin@idudin-vb:~/Documents$ sed '/test1/s/mazafaka/000/' newtest

test1 niga test1 000 test1

niga niga niga mazafaka niga

mazafaka niga mazafaka mazafaka mazafaka

test1 niga test 000 test

niga niga niga mazafaka niga

niga niga niga mazafaka niga

mazafaka niga mazafaka mazafaka mazafaka

i.dudin@idudin-vb:~/Documents$

Чтобы удалить строку (строки) можно использовать команду d (нужно указывать номер удаляемой строки, если не указать то будут удалены все строки)

i.dudin@idudin-vb:~/Documents$ sed '1d' test

niga

mazafaka

test

niga

niga

mazafaka

i.dudin@idudin-vb:~/Documents$ sed '1,5d' test

niga

mazafaka

Можно удалять по фильтру

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

test

niga

niga

mazafaka

i.dudin@idudin-vb:~/Documents$ sed '/mazafaka/d' test

test1

niga

test

niga

niga

Можно указать диапазон строк по фильтру (указывается два фильтра через запятую и будут удалены все строки между этими фильтрами)

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

test22

niga

niga

mazafaka

test

test22

niga

mazafaka

aseohtu

aeou

aoeustnh

i.dudin@idudin-vb:~/Documents$ sed '/test22/,/test22/d' test

test1

niga

mazafaka

niga

mazafaka

aseohtu

aeou

aoeustnh

Ключ -i позволяет записать изменения в исходный файл (а не выводить на экран)

Чтобы вставить строку в поток можно использовать команду i или a

(по умолчанию она вставит текст после или до каждой входящей строки (см. пример))

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

niga

mazafaka

aseohtu

aeou

aoeustnh

i.dudin@idudin-vb:~/Documents$ sed -e 'i0000000' test

0000000

test1

0000000

niga

0000000

mazafaka

0000000

niga

0000000

mazafaka

0000000

aseohtu

0000000

aeou

0000000

aoeustnh

0000000

Вставить строку до указанной

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

i.dudin@idudin-vb:~/Documents$ sed -e '2i\00000' test

test1

00000

niga

mazafaka

Вставить строку перед строкой по фильтру

i.dudin@idudin-vb:~/Documents$ cat test

test1

niga

mazafaka

i.dudin@idudin-vb:~/Documents$ sed -e '/niga/i\00000' test

test1

00000

niga

mazafaka

Вставить в множество файлов (в начало или конец) определенную строку

i.dudin@idudin-vb:~/Documents$ ls

1 100 12 14 16 18 2 21 23 25 27 29 30 32 34 36 38 4 41 43 45 47 49 50 52 54 56 58 6 61 63 65 67 69 70 72 74 76 78 8 81 83 85 87 89 90 92 94 96 98

10 11 13 15 17 19 20 22 24 26 28 3 31 33 35 37 39 40 42 44 46 48 5 51 53 55 57 59 60 62 64 66 68 7 71 73 75 77 79 80 82 84 86 88 9 91 93 95 97 99

i.dudin@idudin-vb:~/Documents$ cat 1

testovaya stroka

1

$i

1

i.dudin@idudin-vb:~/Documents$ for var in `ls -1`; do sed -ie '$a'"$var nigerskaya stroka" $var; done

i.dudin@idudin-vb:~/Documents$ cat 1

testovaya stroka

1

$i

1

1 nigerskaya stroka

i.dudin@idudin-vb:~/Documents$

Заменить целую строку можно через команду c (так же как с командой d, если не указывать конкретные строки для обработки, заменит все входящие строки)

i.dudin@idudin-vb:~/Documents$ cat 11

testovaya stroka

11

$i

11

11 nigerskaya stroka

i.dudin@idudin-vb:~/Documents$ sed -e 'c\test test test' 11

test test test

test test test

test test test

test test test

test test test

i.dudin@idudin-vb:~/Documents$

Номер строки указывается перед командой

i.dudin@idudin-vb:~/Documents$ sed -ie '2c\test test test' 11

i.dudin@idudin-vb:~/Documents$ cat 11

testovaya stroka

test test test

$i

11

11 nigerskaya stroka

Можно воспользоваться фильтром для замены только в нужных строках

i.dudin@idudin-vb:~/Documents$ cat 11

testovaya stroka

test test test

$i

11

11 nigerskaya stroka

i.dudin@idudin-vb:~/Documents$ sed -ie '/11/c\test test test' 11

i.dudin@idudin-vb:~/Documents$ cat 11

testovaya stroka

test test test

$i

test test test

test test test

i.dudin@idudin-vb:~/Documents$

Замена символов

i.dudin@idudin-vb:~/Documents$ sed -ie 'y/e/1/' 11

i.dudin@idudin-vb:~/Documents$ cat 11

t1stovaya stroka

t1st t1st t1st

$i

t1st t1st t1st

t1st t1st t1st

Команда = показывает номер строки перед строкой

Ключ -n запрещает вывод потока (выводит только обработанные строки)

i.dudin@idudin-vb:~/Documents$ sed -ne '3p' 11

$i

iptables

Тоже хорошая статья (более короткая)

https://wiki.archlinux.org/index.php/Iptables_(Русский)

Большая и подробная статья на русском

Чтобы посмотреть текущие правила

iptables -nvL

Что бы сохранить правила в отдельный файл — используйте:

iptables-save > /root/iptables_bkp

Что бы восстановить из него:

iptables-restore < /root/iptables_bkp

Привилегированные порты - порты для использования которых нужно иметь права суперпользователя

Это порты с 0 по 1023

[vandud@desktop ~]$ nc -l -p 88

Error: Couldn't setup listening socket (err=-3) # не разрешило слушать привилегированный порт

[vandud@desktop ~]$ nc -l -p 1088 # прекрасно повисло на прослушивание порта

^C

При добавления правил нужно понимать что после рестарта они пропадут. Поэтому нужно сохранять их в /etc/iptables/iptables.rules

docker,ferm,iptables

При использовании ferm совместно с docker возникает проблема. Докер создает правила на ходу (при создании контейнеров), а ферм про них ничего не знает

Для решения этой проблемы можно использовать ferment (github.com/diefans/ferment)

Лучше использовать ferment-ng, так как в новых версия докера правила создаются иначе

Он ставится через pip и умеет генерировать ферм конфиг для докера

Достаточно в конец ferm.conf дописать

@include '/usr/local/bin/ferment docker config|';

Tables, chains, rules

Каждое правило состоит из критерия (набора условий), действия и счетчика пакетов попавших под это правило. Правило применяется к пакетам подходящим под все условия (критерия)

Каждая таблица служит конкретной цели. Таблицы составляют набор цепочек, которые содержат список правил, организованных в определенном порядке

Цепочки - это упорядоченные последовательности правил (их можно разделить на базовые и пользовательские)

Базовые цепочки создаются по-умолчанию, пользовательские цепочки создаются пользователем)

Принято, что имена базовых цепочек пишутся в верхнем регистре, а имена пользовательских в нижнем

Таблица - это совокупность базовых и пользовательских цепочек, объединенных общим фунуциональным назначением. Имена таблиц пишутся в нижнем регистре

Таблицы:

- raw - пакет проходит таблицу raw до передачи системе определения состояний (может использоваться для маркировки пакетов)

- mangle - содержит правила модификации ip-пакетов и разные специальные преобразования

- nat - подмена адреса отправителя или получателя, проброс портов, итд

- filter - основная таблица, используется по-умолчанию если название таблицы не указано. Используется для фильтрации пакетов

- security - используется для контроля доступа (SELinux)

Таблицы состоят из цепочек правил (правила в цепочках расположены в определенном порядке)

Например таблица по умолчанию filter содержит 3 встроенные цепочки:

- INPUT

- OUTPUT

- FORWARD

А таблица nat содержит:

- PREROUTING (для DNAT)

- POSTROUTING (для SNAT)

- OUTPUT

5 базовых цепочек:

- PREROUTING - для изначальной обработки входящих пакетов

- INPUT - для входящих пакетов, адресованных непосредственно локальному компьютеру

- FORWARD - для проходящих (маршрутизируемых) пакетов

- OUTPUT - для пакетов создаваемых локальным компьютером

- POSTROUTING - для окончательной обработки исходящих пакетов

Также можно создавать собственных цепочки

У всех цепочек есть стандартное правило (политика). Оно применяется к пакету, когда он прошел все остальные правила. То есть политика - это правило по умолчанию

Критерий (условие)

Критерий это логическое условие, которое определяет, соответствует ли пакет этому правилу. В одном правиле может быть несколько критериев (они неявно объединяются логическим AND). Если критерий не указан, то предполагается что правило действует для всех пакетов

Критерий можно инвертировать знаком ! перед ним (логическое НЕ)

Восклицательный знак нужно ставить перед названием критерия, а не между названием критерия и его значением (так стало в новых версиях):--option ! this - is deprecated! --option this - is actual

Универсальные критерии

Универсальные критерии применимы к пакетам независимо от протокола транспортного уровня и они не требуют подключения модулей через ключ -m

-

-p- протокол (tcp, udp, icmp, all, etc). Также протокол можно указать числом или названием из /etc/protocols. После указания протола можно использовать специфичные для него критерии, например--sport,--dportили--icmp-type -

-s- адрес отправителя. Можно указывать как имя, так и адрес (адрес можно указывать с маской в классическом формате или в CIDR). Можно указать более одного адреса разделяя их запятой (для каждого адреса будет созданно отдельное правило)

Стоит понять что команда с множеством адресов перобразуется в несколько команд с одним адресом, поэтому например добавление правил в конец цепочки добавит правила в порядке перечисления адресов, а вставка в начало цепочки добавит правила в порядке обратном порядку перечисления адресов

При использовании доменов нужно знать что они резолвятся в адреса единожды - при создании правила. Если в будущем адрес домена изменится, то на правило это не повлияет, в правиле останется старый адресiptables -I FORWARD -s deimos.vandud.ru -j DROP # команда (используется таблица forward из-за докера) DROP all -- 185.211.247.85 0.0.0.0/0 # итоговое правило которое работаетА вот если попробовать добавить правило для несуществующего хоста, то возникнет ошибка

root@mars:~# iptables -I FORWARD -s deimos.vandaoeuud.ru -j DROP iptables v1.8.2 (nf_tables): host/network `deimos.vandaoeuud.ru' not found Try `iptables -h' or 'iptables --help' for more information. -

-d- то же что и-sтолько destination addressИнтересный момент: если использовать одновременно и

-dи-s, и в обоих критериях по несколько адресов, то в итоге будет созданно d*s правил. То есть все возможные комбинации -

-i- входящий интерфейс. В конце имени интерфейса можно поставить+, тогда под него будут подходить все интерфейсы, имена которых начинаются на слово до плюса. Данный критерий можно использовать в цепочках PREROUTING, INPUT и FORWARD -

-o- исходящий интерфейс. То же что и-i, но для цепочек FORWARD, OUTPUT и POSTROUTING

Критерии специфичные для протоколов

TCP

-

--sport- source-port -

--dport- destination-port

Можно указывать как диапазон - --sport 1:20

-

--tcp-flags- позволяет отфильтровать пакеты по установленным в них tcp-флагам. Синтаксис:--tcp-flags маска установленные-флаги- маска это список флагов на которые смотрим, а установленные-флаги это те флаги, которые установлены на пакете (установленные флаги это подмножество маски, но не наоборот). Те флаги, которые не перечислены в маске - могут быть как установлены, так и нет, на них мы не смотрим вообще

А вот подмножество флагов маска - установленные-флаги должно быть в неустановленном состоянии -

--syn- позволяет отлавливать SYN-пакеты -

--tcp-option- проверка наличия какого-либо tcp-параметра

UDP

-

--sport,--dport- аналогично соотв. критериям из tcp

IPv4

-

-f- позволяет отлавливать фрагменты пакетов начиная со второго -

addrtype- позволяет проверить тип адреса источника и/или назначения с точки зрения подсистемы маршрутизации сетевого стека ядра (UNICAST, LOCAL, UNREACHABLE, etc.)-

--src-type,--dst-type- пренадлежит ли src/dst адрес указанному типу

-

-

ecn- разные проверки ECN -

ttl- проверка поля TTL, можно сравнивать TTL пакета с каким-то значением

ICMP

-

--icmp-type- проверка типа icmp-пакета (допустимые типы можно посмотреть командойiptables -p icmp -h)

Критерии состояния соединения - ConnTrack

В netfilter также есть механизм определения состояний. Он позволяет определить какому состоянию пренадлежит пакет

ConnTrack позволяет делать stateful-фильтрацию

Для протоколов в которых есть понятие "соединение" (tcp), conntrack активно его использует, тесно взаимодействуя с базовой сетевой подсистемой ядра Linux. А в тех протоколах где соединений нет (udp) он вводит его искусственно

У conntrack есть разные модули, которые помогают ему анализировать пакеты и понимать разные факты о них. Например протокол FTP использует два соединения, conntrack это понимает и, проанализировав пакеты управляющего соединения, знает куда будет устанавливаться передающее

С помощью утилит conntrack и iptstate можно наблюдать таблицы состояний соединений

Примерно то же самое что и conntrack показывает cat /proc/net/nf_conntrack

Типы состояний (критерий --ctstate):

- NEW - новое соединение

- ESTABLISHED - уже установленное соединение

- RELATED - дополнительное к уже существующему соединению

- INVALID - пакет должен принадлежать уже сущ. соединению, но такого соединения не зарегистрировано. Обычно такие пакеты дропают

- UNTRACKED - пакет для которого было отключено отслеживание состояния (в таблице raw)

- DNAT, SNAT - пакет был изменен подменой адреса

Типы статусов (критерий --ctstatus):

- EXPECTED - ожидаемое соединение (например передающее соединение в FTP, conntrack проанализировал предыдущие пакеты и понял что скоро будет новое соединение)

- CONFIRMED - подтвержденное соединение (что бы это не значило)

- SEEN_REPLY - соединение по которому поступил ответ, то есть имеет место передача в обоих направлениях

- ASSURED - полностью уставноленное соединение, этот статус присваивается после определенного колчества переданных данных. После присвоения этого статуса увеличивается conntrack timeout

- NONE - нет статуса

Существует также понятие «связанных соединений». Например, когда в ответ на UDP-пакет с нашего хоста удаленный хост отвечает ICMP-пакетом icmp-port-unreachable, формально этот ответ является отдельным соединением, так как использует совсем другой протокол. netfilter отслеживает подобные ситуации и присваивает таким соединениям статус «связанных» (RELATED), позволяя корректно пропускать их через фильтры фаервола.

Красными ромбами обозначен момент передачи пакета в механизм определения состояния

Синими кругами обозначены точки маршрутизации: направлен пакет локальному хосту или это проходящий пакет. На какой сетевой интерфейс нужно направить исходящий пакет, итд

На схеме видно что и входящие и исходящие пакеты первым делом попадают в таблицу raw

Эта таблица предназначена для выполнения действий с пакетами до их обработки системой conntrack

В ней невозможно использовать критерии связанные с conntrack'ом (т.к. до него очередь еще не дошла)

Критерий conntrack предоставляет:

-

--ctstate- позволяет выбрать состояние пакета

Например:iptables -A INPUT -m conntrack --ctstate ESTABLISHED,RELATED -j ACCEPT -

--ctstatus- опеределение статуса соединения -

--ctproto- протокол транспортного уровня. Аналогично критерию-p -

--ctdir- направление пакета-

ORIGINAL- от инициатора к отвечающему -

REPLY- ответ инициатору

-

-

--ctorigsrc,--ctorigdst,--ctreplsrc,--ctrepldst+ 4 таких же критерия, но с приставкойportсправа - позволяют определять адреса/порты источника/назначения в разных направлениях -

--ctexpire- позволяет указать оставшееся до таймаута время жизни соединения (принимает минимально оставшееся время, но также можно указать и диапазон). Важно помнить что таймауты для разных протоколов (и даже на разных стадиях одного протокола) - разные

Дополнительные критерии

Дополнительные критерии можно подгружать с помощью параметра -m. Можно подгружать сразу несколько модулей в одной команде (в одном правиле), но нельзя смешивать параметры (критерии) этих модулей, после каждого модуля строго его параметры

Также допустимо использовать отрицание для каждого критерия (параметра) в отдельности:

-m conntrack ! --ctstate NEW

Справку по модулю можно получить так:

iptables -m название_критерия -h

Список критериев:

-

multiport- позволяет указать несколько (до 15) портовiptables -A DOCKER-USER -p tcp -m multiport --dports 80,81,82,83,84,85,86 -j ACCEPTACCEPT tcp -- anywhere anywhere multiport dports http,81,82,83,84,85,86

Также этот критерий имеет параметр--ports, который объединяет sport и dport -

iprange- позволяет указать диапазон адресов не являющихся подсетью -

mark- позволяет выделять пакеты по маркировке -

connmark- то же что и mark но для соединений -

limit- позволяет ограничить количество пакетов в единицу времени -

hashlimit- то же что и limit но позволяет применять одно правило для групп хостов, подсетей -

connlimit- позволяет ограничивать количество одновременно открытых соединений с каждого IP-адреса -

connbytes- позволяет ограничивать количество переданных байт или пакетов -

quota- позволяет задать квоту в байтах для данного конкретного правилаChain INPUT (policy DROP 13166 packets, 684K bytes) pkts bytes target prot opt in out source destination 3 171 ACCEPT tcp -- * * 0.0.0.0/0 0.0.0.0/0 tcp dpt:33 quota: 200 bytes 9 780 DROP tcp -- * * 0.0.0.0/0 0.0.0.0/0 tcp dpt:33 -

length- ограничение по размеру пакета (размер пакета протокола сетевого уровня (IP, IPv6) за вычетом размера заголовков сетевого уровня) -

recent- мощный критерий, умеет много всего относительно запоминания информации о проходящих через него пакетах и принятия решения на основе собранных знаний. С помощью него можно строить крутые вещи -

u32- супер штука для глубокого анализа трафика. Для него нужно писать программы на местном языке

Если действия не указано, то правило будет работать как счетчик

Путь пакета по цепочкам и таблицам

Схема прохождения пакета:

Чуть более удобная схема:

Как видно, пакет вначале проходит по цепочкам PREROUTING в трех таблицах (raw, mangle, nat)

Важно понимать, что это три разные цепочки (с одинаковым именем) в трех разных таблицах

Далее, пройдя по трем цепочкам, пакет уходит в цепочки INPUT или FORWARD, таблиц mangle и filter

И т.д.

Не важно с какого интерфейса был получен пакет. В каждом случае он обрабатывается одинакого и проходит одинаковый путь по таблицами и цепочкам

Действие над пакетом указывается через ключ -j или --jump. В него передается либо стандартное действие, либо действие расширения, либо переход на пользовательскую цепочку

Примеры стандартных действий:

- ACCEPT

- DROP

- QUEUE

- RETURN

Примеры действий расширений:

- REJECT

- LOG

Если выбрано стандартное действие, то участь пакета ясна (он допускается, отбрасывается, итд)

Если выбран переход на пользовательскую цепочку, то пакет проходит по всем правилам пользовательской цепочки и если ни одно правило из нее не подошло ему, то он возвращается на следующее после перехода правило (см. картинку)

А действия расширений могут вести себя и как переход на пользовательскую цепочку, и как стандартное действие (зависит от расширения)

Более правильными словами: действия расширений могут быть терминальными (как стандартные действия) или нетерминальными (как пользовательские цепочки)

Более подробно про расширения man iptables-extensions

Пользовательские цепочки не могут иметь политику. А также важно, что пакет попадает в пользовательскую цепочку из стандартной. И если ни одно правило из стандартной цепочки не подошло, по пакет просто возвращается в стандартную цепочку как показано на схеме выше

Также важно, если пакет отброшен действием DROP, то он отброшен окончательно. Но если пакет принят действием ACCEPT, то он принят на уровне этой таблицы и цепочки в ней. Он просто продолжает свой путь по следующим цепочкам (как указано на общей схеме)

Комментарии

Можно добавлять комментарии к правилам

Это делается через модуль comment и его параметр --comment (max-len 256 символов)

Пример:

iptables -A DOCKER-USER -p tcp --dport 77 -j DROP -m comment --comment "supper comment"

Результат:

Chain DOCKER-USER (1 references)

target prot opt source destination

RETURN all -- anywhere anywhere

DROP tcp -- anywhere anywhere tcp dpt:77 /* supper comment */

Основные действия

Работа с цепочками

-

iptables -N chain- New chain

-

-F- Flush chain -

-L [chain-name]- List all rules -

-Z- Zero the packet and byte counters in all chains

-

-P- Set Policy for built-in chain

-

-X- Delete user-defined chain. There must be no references to the chain -

-E- Rename user-chain

Работа с правилами

-

-I chain-name [rulenum]- вставить правило в начало или в указанную позицию (при вставке в указанную позицию, уже существующее на этой позиции правило сдвигается вниз) -

-R chain-name rulenum- заменить правило с указанным номером -

-A- добавить в конец -

-C- проверить что такое правило уже есть -

-D- удалить правило по описанию или по номеру

Действие (target)

-

ACCEPT – принять пакет, и передать следующей цепочке (или приложению, или передать для дальнейшего роутинга)

-

DNAT — (Destination Network Address Translation) используется для преобразования адреса места назначения в IP заголовке пакета; если пакет подпадает под критерий правила, выполняющего DNAT, то этот пакет, и все последующие пакеты из этого же потока, будут подвергнуты преобразованию адреса назначения и переданы на требуемое устройство, хост или сеть; действие DNAT может выполняться только в цепочках PREROUTING и OUTPUT таблицы nat, и во вложенных под-цепочках

важно запомнить, что вложенные подцепочки, реализующие DNAT не должны вызываться из других цепочек, кроме PREROUTING и OUTPUT

-

DROP – просто «сбрасывает» пакет и IPTABLES «забывает» о его существовании; «сброшенные» пакеты прекращают свое движение полностью, т.е. они не передаются в другие таблицы, как это происходит в случае с действием ACCEPT

-

LOG — действие, которое служит для журналирования отдельных пакетов и событий; в журнал могут заноситься заголовки IP пакетов и другая полезная информация; информация из журнала может быть затем прочитана с помощью dmesg или syslogd, либо с помощью других программ; обратите ваше внимание так же на цель ULOG, которое позволяет выполнять запись информации не в системный журнал, а в базу данных MySQL и т.п.

-

MARK — используется для установки меток для определенных пакетов; это действие может выполняться только в пределах таблицы mangle; установка меток обычно используется для нужд маршрутизации пакетов по различным маршрутам, для ограничения трафика и т.п.; «метка» пакета существует только в период времени пока пакет не покинул брандмауэр, т.е. метка не передается по сети

-

MASQUERADE — в основе своей представляет то же самое, что и SNAT только не имеет ключа

--to-source; причина тому то, что маскарадинг может работать, например, с dialup подключением или DHCP, т.е. в тех случаях, когда IP адрес присваивается устройству динамически; если у вас имеется динамическое подключение, то нужно использовать маскарадинг, если же у вас статическое IP подключение, то лучше будет использование SNAT -

MIRROR — может использоваться вами только для экспериментов и в демонстрационных целях, поскольку это действие может привести к «зацикливанию» пакета и в результате к «Отказу от обслуживания»; в результате действия MIRROR в пакете, поля source и destination меняются местами и пакет отправляется в сеть; допускается использовать только в цепочках INPUT, FORWARD и PREROUTING, и в цепочках, вызываемых из этих трех

-

QUEUE – ставит пакет в очередь на обработку пользовательскому процессу; оно может быть использовано для нужд учета, проксирования или дополнительной фильтрации пакетов

-

REDIRECT — выполняет перенаправление пакетов и потоков на другой порт той же самой машины; можно пакеты, поступающие на HTTP порт перенаправить на порт HTTP-proxy; удобен для выполнения «прозрачного» проксирования (transparent proxy), когда машины в локальной сети даже не подозревают о существовании прокси; может использоваться только в цепочках PREROUTING и OUTPUT таблицы nat

-

REJECT — используется, как правило, в тех же самых ситуациях, что и DROP, но в отличие от DROP, команда REJECT выдает сообщение об ошибке на хост, передавший пакет

-

RETURN — прекращает движение пакета по текущей цепочке правил и производит возврат следующему правилу в вызывающей (предыдущей) цепочке, если текущая цепочка была вложенной, или, если текущая цепочка лежит на самом верхнем уровне (например INPUT), то к пакету будет применена политика по-умолчанию; обычно, в качестве политики по-умолчанию назначают действия ACCEPT или DROP

-

SNAT — используется для преобразования сетевых адресов (Source Network Address Translation), т.е. изменение исходящего IP адреса в IP в заголовке пакета; SNAT допускается выполнять только в таблице nat, в цепочке POSTROUTING; если первый пакет в соединении подвергся преобразованию исходящего адреса, то все последующие пакеты, из этого же соединения, будут преобразованы автоматически и не пойдут через эту цепочку правил

-

TOS — используется для установки битов в поле Type of Service IP заголовка; поле TOS содержит 8 бит, которые используются для маршрутизации пакетов; важно помнить, что данное поле может обрабатываться различными маршрутизаторами с целью выбора маршрута движения пакета; в отличие от MARK, сохраняет свое значение при движении по сети, а поэтому может использоваться для маршрутизации пакета; лучше всего использовать это поле для своих нужд только в пределах WAN или LAN

-

TTL — используется для изменения содержимого поля Time To Live в IP заголовоке

-

ULOG — система журналирования пакетов, которая заменяет традиционное действие LOG, базирующееся на системном журнале; при использовании этого действия, пакет, через сокеты netlink, передается специальному демону который может выполнять очень детальное журналирование в различных форматах (обычный текстовый файл, база данных MySQL и пр.), может формировать отчёты в CSV, XML, Netfilter’s LOG, Netfilter’s conntrack; подробнее смотрите на домашней странице проекта

Wi-Fi через терминал

В этой статье рассматривается еще один способ подключения к wi-fi (wpasupplicant)

Через утилиту nmcli (скорее всего нет по умолчанию)

Найти нужную wi-fi сеть и информацию о ней

Можно использовать утилиту nmcli

nmcli device wifi

Ключевое слово wifi означает тип девайса (можно увидеть в выводе команды nmcli device)

В выводе список wi-fi точек со следующими полями (пример вывода):

IN-USE SSID MODE CHAN RATE SIGNAL BARS SECURITY

iFree Infra 52 270 Mbit/s 100 ▂▄▆█ WPA1 WPA2 802.1X

Поле BARS это (насколько я понял) просто график поля SIGNAL, а значение в поле SIGNAL указано в процентах.

Подключиться к выбранной точке

Используя ту же утилиту nmcli

nmcli device wifi connect WiFi-Name password Password

После выполнения этой команды даже не нужно вызывать dhclient для получения параметров dhcp (они настраиваются автоматически)

Утилита iwctl/iwd

https://ctlos.github.io/wiki/packages/iwd/

Поднимаем беспроводной интерфейс (если не поднят)

[vandud@thinkpad ~]$ sudo ip link set wlp3s0 up

Подключение

iwctl station wlan0 scan

iwctl station wlan0 get-networks

iwctl station wlan0 connect COSMOPOLITAN

После команды connect будет запрошен пароль от точки доступа.

Далее нужно получить ip-адрес. Для этого достаточно выполнить команду dhclient

Для автоподключения к wi-fi нужно добавить сервис iwd в автозагрузку:

systemctl enable iwd

И добавить в файл /var/lib/iwd/NETWORK.psk такую директиву:

[Settings]

AutoConnect=true

Этот файл уже будет содержать пароль от этой сети (создается после первого подключения)

Для автоматического получения ip-адреса нужно добавить в /etc/iwd/main.conf вот такое:

[General]

EnableNetworkConfiguration=true

Теперь при перезагрузке сервер будет автоматически подключаться к wi-fi

(это нужно для автонастройки ip, по умолчанию dhclient не запускается)

Если указанный выше метод не сработал для dhcp, то можно сделать так:

cat /etc/systemd/network/20-dhcp.network

[Match]

Name=enp*

[Network]

DHCP=ipv4

И нужно сделать reload/enable/start для systemd-networkd.service

Трекпад на thinkpad x240

Сначала нужно установить драйвер

# pacman -S xf86-input-synaptics

Далее нужно изменить параметры загрузки ядра. Происходит тайм-аут по бездействию устройства (трекпоинт или трекпад). Нужно добавить в /etc/default/grub следующие параметры

GRUB_CMDLINE_LINUX_DEFAULT="[уже присутствующие параметры] i8042.nomux=1 i8042.noloop=1 i8042.notimeout=1 i8042.reset=1"

Далее

sudo update-grub

И рестарт системы (чтобы она загрузилась уже с новыми параметрами)

После этих действий у меня стало работать (но вскоре проблема вернулась)

Документация про параметры ядра (искать по i8042)

Вот еще

https://www.linux.org.ru/forum/desktop/9066459

В итоге видимо проблема не на таком низком уровне как я подумал ранее.

Файл /etc/X11/xorg.conf.d/30-touchpad.conf привел к следующему виду:

Section "InputDevice"

Identifier "TouchPad"

Driver "synaptics"

EndSection

Перезагрузил ноут и команда synclient -l стала показывать вывод переменных драйвера synaptics (ранее драйвер не был задействован (возможно в этом была проблема))

Через драйвер synaptics можно настроить все (я был шокирован когда увидел количество различных параметров)

Утилита synclient позволяет менять настройки на лету (без перезагрузки X)

Чтобы настроить клики мыши по тапам (там по тачпаду) нужно выполнить следующую команду

synclient TapButton1=1 TapButton2=3 TapButton3=2

Эти клики можно настроить через утилиту synclient, либо указать в ранее упомянутом конфиге xorg.conf.d

Section "InputDevice"

Identifier "touchpad"

Driver "synaptics"

Option "TapButton1" "1"

Option "TapButton2" "3"

Option "TapButton3" "2"

EndSection

Домашняя система [configs]

Список файлов и директорий, которые нужно бэкапировать:

- ~/.mozilla/*

- ~/.bash_aliases

- ~/.i3/config

Язык (раскладка + переключение)

Вот такая команда работает корректно, пока не определился куда именно ее поместить, в данный момент она находится в ~/.i3/config

exec setxkbmap -layout us,ru -variant dvorak, -option grp:win_space_toggle

exec - для выполнения через конфиг i3 (если надумаю разместить в каком-нибудь bash конфиге, то она не нужна)

Firefox

Директория с конфигами ~/.mozilla/firefox, проще копировать целую ~/.mozilla

При первом запуске, firefox создает в домашней папке эту директорию с дефолтными конфигами. Перед копированием своего конфига, старую директорию нужно удалить.

После копирования своей ~/.mozilla, firefox запускается сразу с нужными настройками, то есть кроме копирования конфигов, больше ничего делать не нужно.

С помощью плагина Firefox color создал тему. Плагин может сразу применять новую тему на лету, а также позволяет сохранить тему как архив.

Вся тема состоит из двух файлов:

- json-манифест

- Картинка (используется для фона)

├── images

│ └── bg-039-717a66ba4d455686088c80f391cb3264.svg

├── manifest.json

manifest.json:

{

"manifest_version": 2,

"version": "1.0",

"name": "vandud-firefox-theme-manjaro-i3",

"theme": {

"images": {

"additional_backgrounds": [

"images/bg-039-717a66ba4d455686088c80f391cb3264.svg"

]

},

"properties": {

"additional_backgrounds_alignment": [

"top"

],

"additional_backgrounds_tiling": [

"repeat"

]

},

"colors": {

"toolbar": "rgb(39, 65, 81)",

"toolbar_text": "rgb(100, 152, 154)",

"frame": "rgb(37, 57, 69)",

"tab_background_text": "rgb(100, 152, 154)",

"toolbar_field": "rgba(0, 0, 0, 0.2)",

"toolbar_field_text": "rgb(100, 152, 154)",

"tab_line": "rgb(28, 171, 176)",

"popup": "rgb(49, 67, 78)",

"popup_text": "rgb(100, 152, 154)",

"tab_loading": "rgb(28, 171, 176)"

}

}

bg-039-717a66ba4d455686088c80f391cb3264.svg:

<svg width="144" height="96" xmlns="http://www.w3.org/2000/svg"><g fill-rule="evenodd" opacity=".3"><path fill-opacity=".1" d="M0 9h180v24H0z"/><path fill-opacity=".2" d="M0-15h180V9H0zm0 96h180v24H0z"/><path fill-opacity=".1" d="M0 0h24v96H0zm48 0h24v96H48zm48 0h24v96H96z"/><path fill-opacity=".1" d="M0 57h180v24H0z"/><path fill-opacity=".2" d="M0 33h180v24H0z"/></g></svg>

Так и не понял как ее установить отдельно

Bash

Все конфиги раскиданы по хомяку

-

~/.bash_aliases

Для работы .bash_aliases, нужно чтобы в .bashrc (или .bash_profile), было прописано следующее:

[[ -f ~/.bash_aliases ]] && . ~/.bash_aliases

Иногда подобная запись уже есть где-либо (в том же .bashrc или где-то еще), но например в manjaro такой записи нет.

i3wm

IPsec tunnel [ubuntu - ubuntu]

https://www.gypthecat.com/ipsec-vpn-host-to-host-on-ubuntu-14-04-with-strongswan

По этой статье все заработало

deb-пакет

Вообще это просто архив типа ar (с сигнатурой !<arch>. [точка это на самом деле 0a - \n])

Буду разбирать на основе zabbix_1.8.22_amd64.deb

Состоит из трех частей:

-

debian-binary - текстовый файл содержащий версию deb

Вот такой командой выделил из основного файла только текстовый файл debian-binary

root@test-slave:/tmp/test# dd if=zabbix_1.8.22-1_amd64.deb of=debian-binary skip=68 count=4 iflag=skip_bytes,count_bytes

Его содержимое

root@test-slave:/tmp/test# xxd debian-binary

0000000: 322e 300a 2.0.

Как видно он содержит 2.0 (0a это \n)

-

control.tar.gz - содержит информацию о deb-пакете и скрипты установки

Выделил из основного файла так

root@test-slave:/tmp/test# dd if=zabbix_1.8.22-1_amd64.deb of=control.tar.gz skip=132 count=299 iflag=skip_bytes,count_bytes

Распаковка

root@test-slave:/tmp/test/control# tar -xzvf control.tar.gz

./

./control

./conffiles

Control содержит следующее

root@test-slave:/tmp/test/control# cat control

Package: zabbix

Priority: extra

Section: checkinstall

Installed-Size: 916

Maintainer: root@test-slave

Architecture: amd64

Version: 1.8.22-1

Provides: zabbix

Description: Zabbix Agent

Conffiles в моем случае был пустым

-

data.tar.xz - содержит файлы для установки

Выделил из основного файла так

dd if=zabbix_1.8.22-1_amd64.deb of=data.tar.xz skip=476 iflag=skip_bytes

Распаковал архив, получилось следующее

root@test-slave:/tmp/test/data# tree .

.

├── data.tar.xz

└── usr

├── local

│ ├── bin

│ │ ├── zabbix_get

│ │ └── zabbix_sender

│ ├── sbin

│ │ ├── zabbix_agent

│ │ └── zabbix_agentd

│ └── share

│ └── man

│ ├── man1

│ │ ├── zabbix_get.1.gz

│ │ └── zabbix_sender.1.gz

│ └── man8

│ └── zabbix_agentd.8.gz

└── share

└── doc

└── zabbix

├── AUTHORS

├── COPYING

├── CREDITS

├── ChangeLog

├── INSTALL

├── NEWS

└── README

В архиве лежат файлы с абсолютными путями, поэтому они просто разархивируются относительно корня и все.

LUKS Cryptsetup

https://wiki.debian.org/ru/Crypt

Подключить диск

cryptsetup luksOpen /dev/sda2 sda2_crypt

Примонтиовать куда надо

mount /dev/mapper/sda2_crypt /mnt/data

Отмотировать

umount /mnt

Отлючить диск

cryptsetup luksClose sdb1_crypt

Для автомонтирования сделал так

В /etc/crypttab

sdb1_crypt /dev/sdb1 none luks

В /etc/fstab

/dev/mapper/sdb1_crypt /mnt/hdd_1tb ext4 defaults 0 0

При загрузке системы будет спрашиваться пароль от диска

Postgresql

https://postgrespro.ru/docs/postgresql/9.5/install-short

Установка

apt install postgresql-9.5

После установки бинарники постгреса хранятся тут: /usr/lib/postgresql/9.5/bin

Создание директории в которой будут храниться базы

mkdir -p /usr/local/pgsql/data

Можно выбрать любую иную директорию

Назначение соответствующих прав на эту директорию:

chown -R postgres:postgres /usr/local/pgsql/data

Создание нового кластера базы данных в созданной директории

sudo -u postgres /usr/lib/postgresql/9.5/bin/initdb -D /usr/local/pgsql/data/

Запуск постгреса

sudo -u postgres /usr/lib/postgresql/9.5/bin/pg_ctl -D /usr/local/pgsql/data/ -l /var/log/postgresql/postgresql-9.5-main.log start

Создание базы

sudo -u postgres /usr/lib/postgresql/9.5/bin/createdb zabbix

Подключение к консоли постгреса

sudo -u postgres psql

psql (9.5.19)

Type "help" for help.

postgres=#

Дамп большой базы по сети

При дампе большой базы может возникнуть проблема с нехваткой места для файла дампа на сервере с базой. Тогда можно дампить сразу на удаленное хранилище.

Можно на сервере с базой запустить вот такую команду (ее можно сделать еще проще, но в моем случае были вынужденные усложнения)

root@cm-db-pgsql-01x:/home/i.dudin_pro# pg_dump -U postgres notify -Fc -E UTF-8 | bzip2 | ssh i.dudin_pro@bk02.g02.i-free.ru -i /home/i.dudin_pro/.ssh/id_rsa "bunzip2 > /var/backups-remote/cm-db-pgsql-01x_UPEADM-9992/notify.2020-06-07.dump"; echo $?

Bash Tricks

Убрать префикс из имен файлов

Например есть куча файлов у которых в названии есть перфикс

В моем случае префикс это _frem_iptables.txt

...

vendors-highscoring-01x.g01.i-free.ru_frem_iptables.txt

vendors-msgpro-filterws-01.g01.i-free.ru_frem_iptables.txt

vendors-web-backend-01x.g01.i-free.ru_frem_iptables.txt

voiceassistant-vas01.aws-eu-west-1.i-free.ru_frem_iptables.txt

vrs02.g01.i-free.ru_frem_iptables.txt

web-backend-01x.g01.i-free.ru_frem_iptables.txt

web-backend-01y.g01.i-free.ru_frem_iptables.txt

web-backend-02x.g01.i-free.ru_frem_iptables.txt

web-backend-02y.g01.i-free.ru_frem_iptables.txt

web-srv2.pro.i-free.ru_frem_iptables.txt

web-srv3.pro.i-free.ru_frem_iptables.txt

wf-vas01.g01.i-free.ru_frem_iptables.txt

zabbix-proxy.l5.i-free.local_frem_iptables.txt

...

Делаю вот так:

for name in `ls -1`; do mv $name ${name%_frem_iptables.txt}; done

-

${var#pattern}- удаляет наименьшую строку с левой стороны, которая соответствует шаблону -

${var##pattern}- удаляет наибольшую строку с левой стороны, которая соответствует шаблону -

${var%pattern}- удаляет наименьшую строку с правой стороны, которая соответствует шаблону -

${var%%pattern}- удаляет наибольшую строку с правой стороны, которая соответствует шаблону

Более подробно это описано в части "Parameter Expansion" в man bash

sshpass и как выполнить команду через sudo

SSHPass

for servername in `cat /tmp/servernames-for-ferm-reload`; do sshpass -p'ПАРОЛЬ' ssh -tt i.dudin_pro@${servername} 'echo ПАРОЛЬ | sudo -S -s /bin/bash -c "/etc/init

.d/ferm reload"';echo $servername; done

<<<

В баше есть перенаправления потоков, и среди них есть штука их трех стрелок

Она добавляет перенос строки в конец переданного ей (но это не точно)

[vandud@desktop ~]$ cat < "zhopa"

bash: zhopa: No such file or directory

[vandud@desktop ~]$ cat << "zhopa"

> ^C

[vandud@desktop ~]$ cat <<< "zhopa"

zhopa

[vandud@desktop ~]$

Это можно использовать в командах которые ждут ввода пользователя

Например openssl s_client после вывода ожидает от пользователя "Q" и только после этого завершается

[vandud@desktop ~]$ openssl s_client -connect smsservisy.ru:443 2>/dev/null | openssl x509 -noout -subject

subject=OU = Domain Control Validated, OU = Gandi Standard Wildcard SSL, CN = *.i-free.com

Q # ввел руками и нажал enter

А если передать туда "Q" через <<<, то работает само

[vandud@desktop ~]$ openssl s_client -connect smsservisy.ru:443 2>/dev/null <<< "Q" | openssl x509 -noout -subject

subject=OU = Domain Control Validated, OU = Gandi Standard Wildcard SSL, CN = *.i-free.com

[vandud@desktop ~]$

А еще в случае с openssl можно сделать так:

echo | openssl s_client aoseuhosaetuaoue

Сжатие/поворот jpeg

Сжатие

Утилита jpegoptim

Пример использования

[vandud@thinkpad Downloads]$ jpegoptim --size=250K IMG_0892.jpg

IMG_0892.jpg 3421x1460 24bit N Exif IPTC ICC JFIF [OK] 1060271 --> 253677 bytes (76.07%), optimized.

Размер можно не указывать, тогда будет оптимизация без потерь качества, но сжатие совсем не значительное (около 1-2 процентов).

Поворот

Утилита convert

convert [input-options] input-file [output-options] output-file

Пример:

convert IMG_0191.jpg -rotate -90 IMG_0191r.jpg

Крутит по часовой стрелке

heic -> jpg

$ heif-convert IMG_0583.heic recomendations.jpg

LA

https://firstvds.ru/technology/nagruzka-na-server-opredelenie-prichin

В выводе top есть строка CPU:

- us (user) - Использование процессора пользовательским процессами

- sy (system) - Использование процессора системным процессами

- ni (nice) - Использование процессора процессами с измененным приоритетом с помощью команды nice

- id (idle) - Простой процессора. Можно сказать, что это свободные ресурсы

- wa (IO-wait) - Говорит о простое, связанным с вводом/выводом

- hi (hardware interrupts) - Показывает сколько процессорного времени было потрачено на обслуживание аппаратного прерывания

- si (software interrupts) - Показывает сколько процессорного времени было потрачено на обслуживание софтверного прерывания

- st (stolen by the hypervisor) - Показывает сколько процессорного времени было «украдено» гипервизором

Командой atop -l -c -d1 можно посмотреть кто грузит диск

VIM

Как установить плагин в vim

curl -fLo ~/.vim/autoload/plug.vim --create-dirs \

https://raw.githubusercontent.com/junegunn/vim-plug/master/plug.vim

Эта команда добавит менеджер плагинов.

Далее в .vimrc добавляем плагины вот так:

set nu

set expandtab

set tabstop=2

set incsearch

syntax on

call plug#begin('~/.vim/plugged')

Plug 'stephpy/vim-yaml'

Plug 'preservim/nerdtree'

Plug 'morhetz/gruvbox'

call plug#end()

colorscheme gruvbox

set background=dark

map <C-n> :NERDTreeToggle<CR>

Строки с call нужны обязательно, между ними и указываются плагины.

И в конце чтобы новые плагины установились нужно:

- Подгрузить конфиг файл

:source %или:source PATH_TO_vimrc(если конфиг был изменен вимом же только что), либо перезайти в вим. - Выполнить

:PluginInstall

Два монитора

xrandr --auto --output DP2 --mode 1366x768 --left-of eDP1

Внешний справа:

xrandr --output eDP1 --auto --pos 0x312 --output DP2 --auto --pos 1366x0

Внешний сверху:

xrandr --output eDP1 --auto --pos 0x1080 --output DP2 --auto --pos -276x0

CAPS -> ESC

setxkbmap -option "caps:swapescape"

Что это было перманентным, можно засунуть в .bashrc

Bluetooth

Запустите интерактивную команду bluetoothctl. После этого можно ввести help для получения списка доступных команд:

- Включите питание контроллера, введя

power on. По умолчанию оно отключено. - Введите

devices, чтобы увидеть MAC-адрес устройства для сопряжения. - Войдите в режим обнаружения устройств при помощи команды

scan on, если нужного вам устройства нет в списке. - Включите агент при помощи

agent on. - Введите

pair MAC-адрес, чтобы осуществить сопряжение (работает автодополнение по tab). - При использовании устройства без PIN, возможно, потребуется подтверждение, прежде чем оно сможет успешно переподключиться. Для этого введите

trust MAC-адрес. - Наконец, используйте

connect MAC-адресдля установки соединения.

# bluetoothctl

[bluetooth]# agent KeyboardOnly

[bluetooth]# default-agent

[bluetooth]# power on

[bluetooth]# scan on

[bluetooth]# pair 00:12:34:56:78:90

[bluetooth]# connect 00:12:34:56:78:90

[bluetooth]# trust 00:12:34:56:78:90

Чтобы устройство было активно после перезагрузки, необходимо включить автовключение bluetooth:

/etc/bluetooth/main.conf

[Policy]

AutoEnable=true

Firefox error: NS_ERROR_FILE_CORRUPTED

С такой ошибкой сайт не загружается корректно (не подгружается часть страницы). Я выполнил в консоли браузера такое:

localStorage.clear()

sessionStorage.clear()

И стало работать как надо.

DNS NetworkManager

По умолчанию NetworkManager сам настраивает DNS и у него есть конфиги где можно указать как именно ему это нужно делать.

Но мне было проще отключить автонастройку и делать это через /etc/resolv.conf

Для этого нужно в /etc/NetworkManager/NetworkManager.conf внести:

[main]

dns=none

И все, теперь после перезагрузки NM не будет затирать мои изменения в resolv.conf

Сколько ресурсов "продано" на хостере

Виртуализация qemu/kvm. Команда ниже посчитает проданные ядра.

SUM=0;for i in `sudo grep vcpu /etc/libvirt/qemu/autostart/* | grep -o ">[[:digit:]]<" | grep -o "[[:digit:]]"`; do let SUM+=$i; done; echo $SUM

Vagrant

Инициализация

Чтобы инициализировать виртуалку, нужно ввести команду:

vagrant init ubuntu/xenial64

Она создаст файл Vagrantfile в текущей дериктории. В этом файле содержится конфигурация (на ruby). А также после этой команды будет скачан образ указанной системы с серверов vagrant

Примерно по такому пути находится скачанный образ виртуалки: /home/vandud/.vagrant.d/boxes/ubuntu-VAGRANTSLASH-xenial64/20200617.0.0/virtualbox

Вот тут можно выбрать подходящий образ

В конфиге можно редактировать параметры виртуалки (добавить памяти и прочее)

Старт выполняется командой vagrant up

Для подключения к виртуалке нужно использовать команду vagrant ssh (виртуалка слушает порт для ssh на хостовой машине, но там по-умолчанию доступ только по ключу, который есть у vagrant'a)

Традиционно в вагранте пользователь по-умолчанию - vagrant (пароль такой же как имя)

Директория из которой запускалась виртуалка (в которой лежит Vagrantfile) прокидывается в виртуалку по пути /vagrant (доступ и на чтение и на запись, поэтому нужно быть аккуратным)

[vandud@desktop vagrant]$ touch testfile

[vandud@desktop vagrant]$ vagrant ssh

vagrant@ubuntu-xenial:~$ cd /vagrant/

vagrant@ubuntu-xenial:/vagrant$ ll

total 60

drwxr-xr-x 1 vagrant vagrant 4096 Jun 23 15:01 ./

drwxr-xr-x 24 root root 4096 Jun 23 14:53 ../

-rw-r--r-- 1 vagrant vagrant 0 Jun 23 15:01 testfile

-rw------- 1 vagrant vagrant 42191 Jun 23 14:53 ubuntu-xenial-16.04-cloudimg-console.log

drwxr-xr-x 1 vagrant vagrant 4096 Jun 23 14:32 .vagrant/

-rw-r--r-- 1 vagrant vagrant 3010 Jun 23 15:01 Vagrantfile

Команды управления

- Перезагрузка (выключение и включение, а не просто обновление конфига) -

vagrant reload - Выключение/приостановка -

vagrant halt/suspend - Пробуждение приостановленной ВМ -

vagrant resume - Удаление виртуалки (конф. файлы останутся нетронутыми) -

vagrant destroy - Чтобы удалить и файлы ВМ нужно добавить ключи -f -